안녕하세요. Window에 Apache Spark 설치 방법을 말씀드리겠습니다.

설치하기 정말 힘드시죠? 저 또한 그랬습니다.................

이 글은 제가 SQL수업에서 Apache Spark를 설치하면서, 배운 것을 최대한 쉽게 작성해봤습니다. 이대로 했는데 오류가 발생하면, 어떻게 하면 좋을지는 글의 맨 아래 부분을 참고해주세요!

1. Java 설치 (JDK11설치)

- 먼저 Java가 설치되어 있는지 확인해주세요. 설치되어있다면 버전을 확인하고 11이아니면, 기존 버전을 삭제하고 설치 진행해주세요.

- 아래 링크에서 최신 버전이 아닌 11로 설치해주세요.

- www.oracle.com/kr/java/technologies/javase-jdk11-downloads.html

2. Python 설치

- Python은 설치했다면, 따로 설치 안 하셔도 됩니다.

- 미 설치하신 분은 아래 링크에서 Python버전 상관없이 가장 최신 버전으로 설치해주세요.

- https://www.python.org/downloads/

3. Java와 Python 설치 확인

- (그림 1) 키보드에서 (window + R) 버튼을 누르고, 'cmd'라고 입력 후 확인을 눌러주세요.

- (그림 2) java와 python이 잘 설치됐는지 확인합니다.

※주의 사항※

아래 '★'내용 읽기 싫으면, 아래 링크에서 받으라고 하는 버전 받으면 됨, 최신 버전 받고 싶으면 '★' 읽어야 함.

★4번과 5번에서 파일을 다운로드할 텐데. 4번에 적힌 hadoop버전과 5번의 버전은 같아야 합니다.

★예를 들어서 4번에서 다운로드한 게 'spark-3.3.0-bin-hadoop3.tgz'이라고 하면, hadoop뒤에 3이 적혀있죠?

그럼 5번에서 hadoop3 버전을 받아야 합니다.

★버전 같아야 하는 이유 : spark는 hadoop이 있어야 한다. 분산 처리 환경으로부터 데이터를 '하나의 실행 환경'에서 다루는 것처럼 해줘야 하기 때문이다.

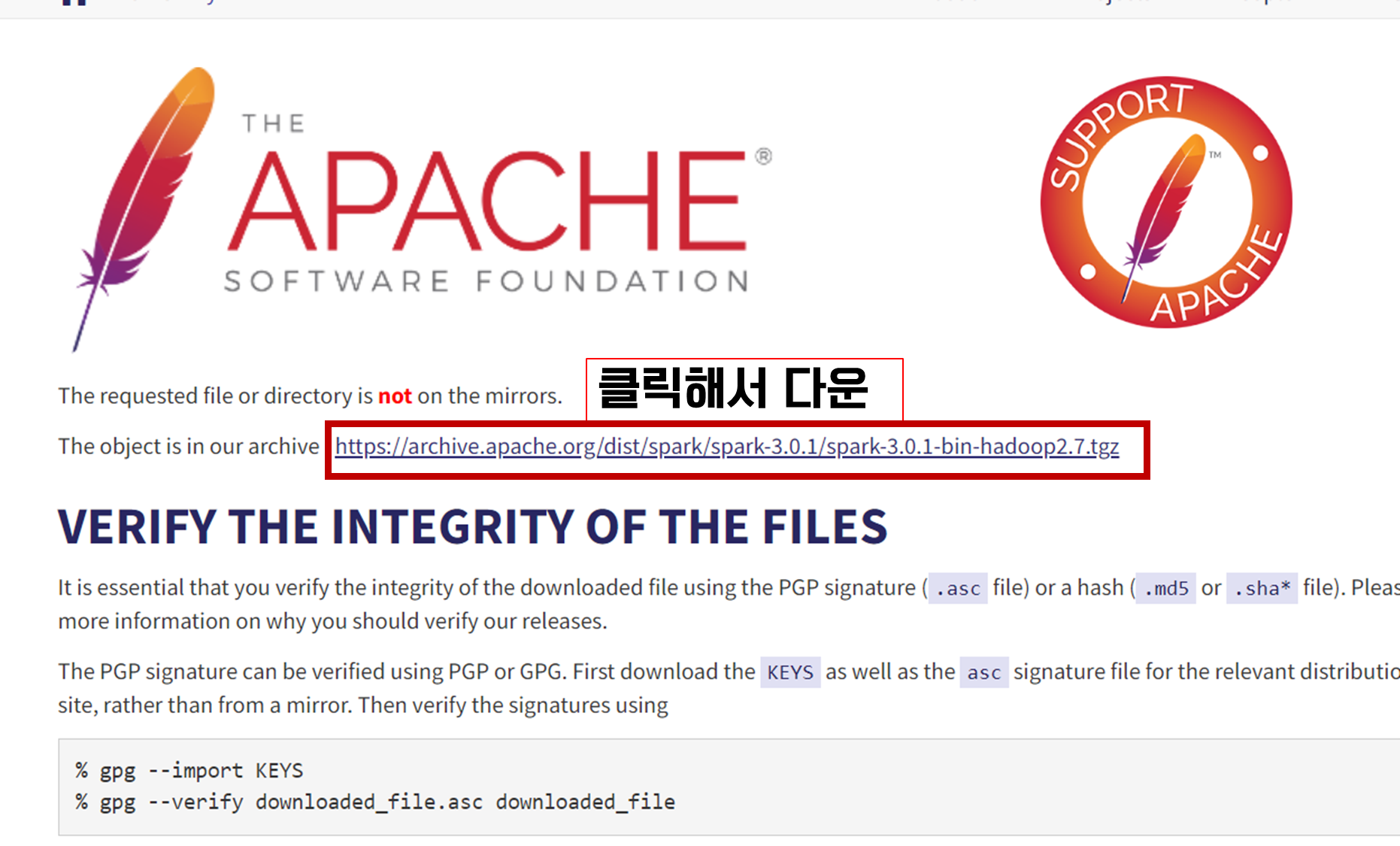

4. SPARK 3.0.1-hadoop2.7다운

- 아래 링크에서 spark를 다운로드할 겁니다. 위에 적힌 주의사항 꼭 읽고 오세요.

https://www.apache.org/dyn/closer.lua/spark/spark-3.0.1/spark-3.0.1-bin-hadoop2.7.tgz - 다운로드하는 파일은 tgz파일인데요. 알집으로 압축을 풀어야 하니 알집이 없으면 꼭 다운로드하세요.

알집 다운 : https://www.altools.co.kr/download/ALZip.aspx

5. winutils.exe(hadoop-2.7.7)다운

6. 폴더 만들기

- c드라이브에 Spark와 Hadoop이라는 폴더를 만들어주세요.(★C드라이브에 만들기 싫은 사람은, 7번 환경 변수 설정에서 경로 설정할 때 꼭 폴더 경로를 반영해줘야 합니다)

- 4번에서 다운로드한 스파크 압축 파일을 스파크 폴더로 옮긴 후 압축을 풀어주세요.

- 5번에서 다운로드한 파일은 Hadoop이라는 폴더에 bin이라는 폴더를 만들고 bin에 넣어주세요.

7. 환경 변수 설정

- 윈도우를 검색해서 '시스템 환경 변수 편집' 클릭 → 환경 변수 클릭해주세요.

- 아래와 같은 '환경 변수' 화면이 나오는데요. <첫 번째. user>와 <두 번째. 시스템>으로 나눠져 있습니다.

- 첫 번째, user변수입니다.- 2개를 새로 만들고 1개를 편집할게요.

- 새로 만들기 버튼을 누르면, 아래의 이미지처럼 뜹니다.

- 2개를 새로 만들어 줄게요. (\는 키보드의 ₩버튼입니다)

(1) 변수 명: HADOOP_HOME

값: C:\Hadoop

(2) 변수 명: SPARK_HOME

값: C:\Spark\spark-3.0.1-bin-hadoop2.7

(★위에서 설치하라고 한 버전이 아닌, Spark 다른 버전을 설치했다면 그 버전에 맞게 바꿔줘야 합니다. 4번에서 압축 해제한 파일 명입니다)

- 1개를 편집해줄게요.

- 변수명 path 편집을 누르고, 새로 만들기를 눌러 두 개를 추가해줍니다.

1) %SPARK_HOME%\bin

2) %HADOOP_HOME%\bin

- 두 번째, 시스템 변수에서는 1개를 새로 만듭니다. 첫 번째에서 user변수 만들 때랑 똑같이 하면 됩니다.

(※여기서 java를 만들지 않았는데 java가 있다면, 이미 설치된 java버전이 있기 때문입니다. 1번에서 이미 설치된 java가 있는지 확인을 해야 하는 이유입니다. 우리가 설치한 java가 아닌 다른 버전을 확인 후 삭제해줘야 합니다!) - (1) 변수 명: JAVA_HOME

값: C:\Program Files\Java\jdk-11.0.16

(※jdk뒤의 숫자는 본인이 다운 받은 버전의 숫자를 확인후, 작성해주세요.)

8. Spark 정상 설치 확인

- 3번에서 윈도+R로 cmd창을 열었던 것을 똑같이 반복해서 검은색 화면을 모니터에 띄웁니다.

- spark-shell을 입력해서, 아래와 같은 화면이 나오면 성공적으로 설치된 것입니다!

최대한 쉽게 이미지와 함께 방법을 작성해보았는데요!

만약, 오류가 뜬다면,

1) 7번 환경 변수 설정에 오타가 없는지 확인해보세요!

2) 6번 폴더를 c드라이브에 만들었는지 확인해보세요. (아래에 더 자세한 설명)

3) java 이전 버전이 있는지 확인해보세요.

4) 4번과 5번에서 다운로드한 하둡버전이 일치하는지 확인해보세요.

5) spark폴더에 들어가서, spark-shell cmd파일을 직접 실행해보세요.

6) 재부팅하고 다시 해보세요!

7) 전부 삭제하고 다시 설치해보세요!

8) 구글 신을 찾아보세요!

2) 번 오류는 제가 만난 오류인데요. 저는 환경 변수까지 잘 설정했는데, 마지막 정상 설치 단계인 cmd 창에서 'spark-shell'은(는) 내부 또는 외부 명령, 실행할 수 있는 프로그램, 또는 배치 파일이 아닙니다.라고 나왔어요! 확인해보니 6번 폴더를 c드라이브에 만들지 않았는데 7번 환경 변수 설정 경로에 'C:\'를 지정해서 그렇더라고요. 이 경우는 c드라이브로 폴더를 옮기거나 7번 환경 변수 설정 시 경로를 맞춰주면 됩니다!

설치까지 마친 당신에게 박수를 짝짝짝!!! 설치를 해냈으니 반은 해낸 것입니다!

참고한 블로그 링크

'💻 SQL > 🎸기타 팁' 카테고리의 다른 글

| [Python] Jupyter notebook사용해서 MY SQL에 csv파일 Import하는 방법 (0) | 2022.08.17 |

|---|---|

| [Git과 GitHub] Visual Studio Code로 commit, push, pull, 원격 저장소 만드는 방법 (0) | 2022.08.05 |

| [WEB] 현업에서 javaScript를 바로 쓰지 않고 React를 쓰는 이유 (+React에서 mui.com 활용하기) (0) | 2022.08.04 |

| [WEB] URL이란 무엇인가? (0) | 2022.08.01 |

| [메타버스] 게더타운(Gater.town)에서 400명이 회의를 한다고?!! (0) | 2021.08.11 |